大數(shù)據(jù)實戰(zhàn) 基于Flink+Kafka的互聯(lián)網(wǎng)日志實時收集與計算方案

在當今的互聯(lián)網(wǎng)業(yè)務中,用戶行為、系統(tǒng)運行、網(wǎng)絡請求等每時每刻都在產(chǎn)生海量的日志數(shù)據(jù)。這些數(shù)據(jù)蘊含著巨大的價值,是進行業(yè)務監(jiān)控、用戶行為分析、性能優(yōu)化和智能決策的基石。因此,構(gòu)建一個高效、穩(wěn)定、可擴展的日志實時收集與計算系統(tǒng),已成為企業(yè)數(shù)據(jù)驅(qū)動戰(zhàn)略的核心環(huán)節(jié)。本文將介紹一個經(jīng)典的、在業(yè)界廣泛應用的簡單而有效的實時大數(shù)據(jù)處理方案。

一、 方案核心架構(gòu)概述

本方案采用業(yè)界成熟的Lambda架構(gòu)思想,構(gòu)建一個輕量級的實時數(shù)據(jù)處理流水線。其核心目標是實現(xiàn)從日志產(chǎn)生、到實時收集、再到快速計算與服務的端到端低延遲處理。主要組件包括:

- 數(shù)據(jù)源(Log Source): 指各類Web服務器(如Nginx、Tomcat)、應用程序、移動端APP等產(chǎn)生的原始日志文件或日志流。

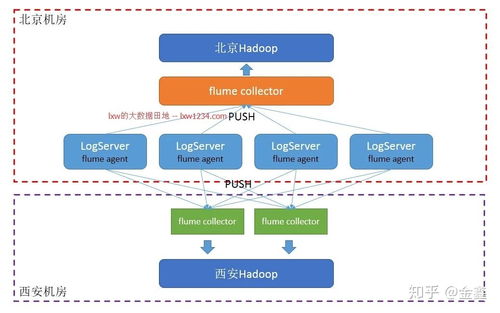

- 實時收集層(Collection Layer): 負責從各個分散的源頭高效、可靠地采集日志數(shù)據(jù),并將其匯聚到中央消息隊列。這里我們選用Apache Flume或Filebeat作為采集Agent。它們輕量、高效,支持斷點續(xù)傳,能實時監(jiān)控日志文件的變化并將新數(shù)據(jù)發(fā)送出去。

- 消息緩沖隊列(Message Queue): 作為系統(tǒng)的“流量洪峰緩沖池”和“解耦器”。收集層的數(shù)據(jù)首先被推送到這里,以平衡數(shù)據(jù)生產(chǎn)與消費的速度差異,并提高系統(tǒng)的魯棒性。Apache Kafka是本方案的理想選擇,它具有高吞吐、可持久化、分布式和容錯的特性,非常適合日志流場景。

- 實時計算引擎(Stream Processing Engine): 這是方案的核心,負責從Kafka中實時消費數(shù)據(jù),并執(zhí)行復雜的轉(zhuǎn)換、聚合、分析和過濾邏輯。我們選用Apache Flink。相比其他流處理框架(如Storm、Spark Streaming),F(xiàn)link提供了真正的流處理語義(低延遲、高吞吐)、精確一次(Exactly-once)的容錯保證,以及豐富的API(DataStream API),非常適合需要復雜事件處理和狀態(tài)管理的實時分析任務。

- 存儲與輸出層(Sink Layer): 經(jīng)過Flink處理后的結(jié)果,需要被存儲下來以供查詢或直接推送到下游服務。常見的輸出目標包括:

- 實時儀表盤/告警系統(tǒng): 將聚合后的指標(如每分鐘PV/UV、錯誤率、API響應時間)實時推送到Elasticsearch + Kibana或Grafana,用于可視化監(jiān)控和設置閾值告警。

- 在線服務數(shù)據(jù)庫: 將用戶畫像標簽、實時排行榜等結(jié)果寫入Redis或HBase,供在線業(yè)務系統(tǒng)(如推薦系統(tǒng)、風控系統(tǒng))低延遲調(diào)用。

- 離線數(shù)倉: 為了支持歷史數(shù)據(jù)回溯和更復雜的批處理分析,原始日志或輕度聚合后的數(shù)據(jù)也可以被寫入HDFS或數(shù)據(jù)湖(如Iceberg),進入離線數(shù)倉(如Hive)的范疇。

二、 一個典型的分析服務場景:實時流量大屏

假設我們需要為電商網(wǎng)站搭建一個實時流量監(jiān)控大屏,核心指標包括:總訪問量(PV)、獨立訪客數(shù)(UV)、各API接口的請求量與平均耗時、地域分布、熱門商品點擊流等。

數(shù)據(jù)處理流程如下:

- 日志生成與收集: Nginx服務器上配置JSON格式的訪問日志。Filebeat Agent部署在每臺服務器上,監(jiān)控日志文件,并將新的日志行實時發(fā)送到Kafka的

raw<em>nginx</em>logTopic中。 - 數(shù)據(jù)接入與解析: Flink作業(yè)從Kafka的

raw<em>nginx</em>logTopic消費原始日志字符串。在Flink中,我們使用DataStreamAPI,首先對每行日志進行解析(Parse),將其從JSON字符串轉(zhuǎn)換為結(jié)構(gòu)化的Java/Python對象(包含字段如:timestamp, url, method, status, responsetime, userid, ip, user_agent等)。 - 實時計算與聚合:

- PV統(tǒng)計: 直接對解析后的所有日志事件進行滾動窗口計數(shù)(例如,每5秒計算一次過去1分鐘的PV)。使用Flink的

TumblingWindow。

- UV統(tǒng)計: 基于

user_id(或?qū)P+User-Agent進行去重標識)進行去重計數(shù)。這里需要使用Flink的KeyedStream和狀態(tài)(State)來管理窗口內(nèi)的唯一用戶集合,或使用HyperLogLog等概率數(shù)據(jù)結(jié)構(gòu)進行近似統(tǒng)計以節(jié)省內(nèi)存。

- API性能分析: 以

url和method為Key進行分組,在滑動窗口內(nèi)計算每個API的請求次數(shù)、平均response_time、95分位響應時間以及錯誤(如status>=500)次數(shù)。

- 地域分析: 在流中調(diào)用IP地址庫查詢服務(或使用本地庫),將

ip字段轉(zhuǎn)換為省份、城市信息,然后按地域進行聚合統(tǒng)計。

- 熱點商品追蹤: 通過過濾和分析訪問商品詳情頁(如URL包含

/product/)的日志,實時統(tǒng)計不同商品ID的點擊量,并輸出Top N列表。

- 結(jié)果輸出與服務: 將上述各個聚合計算的結(jié)果流,分別寫入不同的Sink:

- PV/UV、API性能等時間序列指標,寫入Elasticsearch。Kibana配置對應的儀表盤,即可實現(xiàn)秒級更新的可視化圖表。

- 實時熱門商品Top N列表,寫入Redis的Sorted Set,供前端大屏直接調(diào)用展示。

- 原始明細日志或?qū)挶頂?shù)據(jù),可以同時寫入Kafka的另一個Topic,供下游其他實時作業(yè)消費,或由Flink同步寫入HDFS作為離線備份。

三、 方案優(yōu)勢與特點

- 低延遲與高吞吐: Kafka+Flink的組合能夠輕松應對每秒百萬級別的日志處理,端到端延遲可控制在秒級甚至毫秒級。

- 高可靠與容錯: Kafka保證數(shù)據(jù)不丟失,F(xiàn)link的Checkpoint機制保證了計算狀態(tài)的精確一次(Exactly-once)處理語義,整個管道在節(jié)點故障時能自動恢復。

- 高可擴展性: 每個組件(Kafka, Flink)都是分布式的,可以通過增加節(jié)點來線性提升系統(tǒng)的處理能力。

- 架構(gòu)解耦: 日志收集、消息隊列、實時計算、存儲展示各層職責清晰,通過標準接口(如Kafka Topic)連接,便于獨立開發(fā)、維護和擴容。

- 技術(shù)棧成熟: 所采用的均為Apache頂級開源項目,社區(qū)活躍,文檔豐富,有大量生產(chǎn)實踐案例可供參考。

四、

本方案——以 Filebeat/Flume(采集) → Kafka(緩沖) → Flink(計算) → ES/Redis(存儲服務) 為核心的數(shù)據(jù)流水線,提供了一個完整、高效且易于實施的互聯(lián)網(wǎng)日志實時處理藍圖。它不僅能滿足實時監(jiān)控和告警的需求,更能為實時推薦、風控、個性化營銷等高級分析服務提供源源不斷的實時數(shù)據(jù)燃料。企業(yè)可以根據(jù)自身的數(shù)據(jù)規(guī)模和技術(shù)儲備,從處理核心業(yè)務日志開始,逐步迭代和擴展此架構(gòu),最終構(gòu)建起強大而靈活的企業(yè)級實時數(shù)據(jù)能力。

如若轉(zhuǎn)載,請注明出處:http://www.p509.cn/product/46.html

更新時間:2026-01-11 18:31:44